AUDITORÍA SEO

-ANÁLISIS DE INDEXABILIDAD-

1.NÚMERO DE PÁGINAS INDEXADAS EN GOOGLE

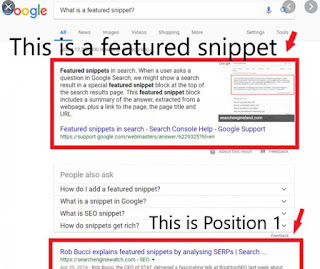

Analizamos las SERP:

Número de páginas indexadas

Aparecen las páginas más importantes en primer lugar

¿Son los snippets descriptivos y atractivos?

¿Son los títulos relevantes y únicos?

¿Hay subdominios indexados?

¿Son otros sitios?

¿Son sitios en desarrollo?

¿Son pruebas?

2. ANÁLISIS DE LA CACHÉ

Analizamos la web en “Versión solo texto” (con Web Developer también se puede simular la visión caché desactivando JavaScript, CSS e imágenes):

Buscamos la recencia (la última vez que pasó el bot de Google)

¿Hay texto de tamaño distinto? ¿Se usan marcas de jerarquía donde se debe?

Revisión de contenido:

¿Hay contenido duplicado?

¿Está el menú y el resto de enlaces?

¿Encuentras marcas de jerarquía?

¿Observas algo extraño en la versión de Solo Texto de la caché de Google de página?

Problemas de indexabilidad

Splash-pages

Páginas pre-home

Flash / Silverlight

Frames

3. GOOGLE SEARCH CONSOLE

Cobertura

¿En total es coherente con el inventario de contenido de nuestro sitio?

¿La tendencia es lógica?

¿El número de páginas excluidas es superior al de válidas?

¿Hay una correlación entre páginas indexadas y excluidas?

¿La caída de páginas indexadas afecta el rendimiento?

Tomaremos en consideración los datos de Cobertura con respecto al comando Site de Google.

Inspección de URLs

Páginas con error (El pluggin Link Redirect Trace también indica el código HTTP devuelto)

¿Aparece todo el HTML de la página?

¿Es visible el contenido?

¿La página devuelve 200?

¿Se han bloqueado recursos?

*La herramienta WMTIPS es una herramienta de análisis de indexabilidad muy interesante.

Errores de rastreo (Cobertura)

Páginas con error

Revisar el número de errores y advertencias

Revisar su tendencia

Revisar su clasificación según el estado, la tendencia y el número de páginas

Páginas excluidas

Analizar sus tipos, número, tendencia, ejemplos, etc.

Puede haber páginas excluidas de forma intencionada, en ese caso no son errores

Excluidas por la etiqueta " nonindex": Google ha encontrado una directiva "nonindex"

Bloqueada por la etiqueta "nonindex"

Bloqueada por robots.txt

- No se ha encontrado (404)

Rendimiento del sitio

Cuando el tiempo de descarga aumenta, Google puede rastrear menos páginas

Auditar sitemaps

¿Se han enviado sitemaps?

¿Se ha consultado recientemente?

¿Hay errores?

¿Cuántas URL se han enviado?

¿Hay errores?

¿Cuántas páginas se han indexado?

¿Se están excluyendo URLs?

¿Qué tendencia hay?

¿Qué tipos de errores se producen?

Títulos/ descripciones duplicadas

Página alternativa con etiqueta canónica adecuada: la página es un duplicado de otra que Google considera canónica. No hay que hacer nada.

Duplicada: el usuario no ha indicado ninguna versión canónica. La página tiene algún duplicado, pero no se ha indicado que ninguno sea la versión canónica. Indicar cuál es la versión canónica de esta página de forma explícita.

Duplicada: Google ha elegido una versión canónica diferente a la del usuario: la URL canónica indicada no es correcta. Por lo general, se debe canonicalizar la URL correcta.

Robots.txt

4.SCREAMING FROG

Número de páginas HTML rastreadas

Response codes: ¿Hay errores?

¿Cuántas páginas cumplen los requisitos técnicos para ser indexables?

Para analizar Sitemaps

Mode > List

Seleccionamos Upload > Download XML Sitemap

Comprobamos que todas las URL sean indexables y que el número total sea correcto.

Identificamos el sitemap en la configuración del rastreo

Nos permite cruzar el rastreo de Screaming Frog con la lista de archivos sitemap. Con esto detectamos

URLS que no están en el sitemap

URLS huérfanas

Canonical

¿Todas las páginas tienen canonical? (Filtro canonical/no canonical)

¿Referencian a sí mismas o hay canonicalizadas? (Filtro canonical self referencing / Canonicalised)

Contenido duplicado

Pestaña Page Title y Filtro Duplicate

Otras formas de buscar thin content, pestaña content y filtro:

Exact duplicates

Near duplicates

Low content pages

Robots.txt

¿Hay recursos bloqueados por el archivo robots.txt?

Pestaña: Response Codes

Filtro: Blocked by Robots.txt

¿Hay recursos bloqueados por la meta robots?

Pestaña: Directives

Filtro: No index

-ANÁLISIS DE LOGS DE SERVIDOR-

SCREAMING FROG

En esta herramienta cargamos:

Log del servidor

Lista de URLS a analizar

Filtramos por bots

Obtenemos KPI relacionados con el rastreo

Análisis de rastreo de URLS:

¿Son correctos los recursos más rastreados?

¿Hay recursos con errores o inconsistencias en la respuesta (no siempre devuelven el mismo código)?

Análisis de rastreo de directorios:

¿Son los directorios más relevantes los más rastreados?

¿En qué directorios se producen errores?

¿Se rastrean directorios irrelevantes?

-AUDITORÍA TÉCNICA (VERSIÓN MÓVIL)-

¿El sitio es compatible con dispositivos móviles? ¿Qué tipo de implementación hay en el sitio?

¿GSC ha detectado errores en la versión móvil?

¿De qué tipo son los errores?

¿En qué tipo de páginas se producen?

-SEGURIDAD-

¿Funciona con protocolo seguro HTTPS?

Si se intenta acceder de forma no segura con HTTP, ¿se ha implementado una redirección 301 a la URL equivalente HTTPS?

Todos los enlaces del sitio deben tener en su href la URL en versión segura HTTPS

Todos los elementos referenciados (imágenes, CSS, JavaScript, fuentes, etc), tanto internos como externos deben estar en versión segura HTTPS.

Lo podemos comprobar con Screaming Frog, en su pestaña Protocol. Otras herramientas como Ryte o SEMRush advierten de problemas de seguridad en sus crawlers.

-CONFIGURACIÓN INTERNACIONAL-

CACHÉ

Etiquetas de enlace alternate/hreflang. Los errores más comunes:

Faltan enlaces recíprocos: si hay una relación de una página A a una página B, desde B debe haber un recíproco a A.

Códigos de idioma incorrectos:

Para el idioma: ISO 639-1

Para la región: ISO 3166-1 Alpha2

GOOGLE SEARCH CONSOLE

¿Se ha seleccionado el país objetivo del sitio?

¿Es coherente con la configuración alternate/hreflang?

HERRAMIENTA IP LOCATION

Localización del servidor

-RELEVANCIA DE CONTENIDOS-

SCREAMING FROG

En los TITLES, revisar:

Tildes

Duplicados

Extensión

Relevancia

Metadescripciones

Sin metadescripción

Duplicados

Extensión

No relevantes

Etiquetas de jerarquía H1

Texto alternativo en imágenes

Anchor Text (Bulk Export > All Anchor Text)

Anchor text no relevantes con la página de destino

Anchor text sobreoptimizados en los que se haya abusado de la palabra clave

WEB DEVELOPER

Etiquetas de jerarquía Hn

Diagnóstico por tipo de plantilla del sitio

Páginas home o listado de elementos

Páginas de contenidos como noticias o fichas de productos

Texto alternativo en imágenes

Imágenes sin texto alternativo o con texto alternativo vacío

Textos alternativos no relevantes

Textos alternativos engañosos o sobreoptimizados

¿El CMS permite incluir textos alternativos en todas las imágenes?

Descartar imágenes secundarias o relacionadas con el diseño de la página

CACHÉ

Etiqueta de jerarquía Hn

Imágenes: texto alternativo

Anchor text:

WEB

Texto incrustado en imágenes

Orden de carga (Con Web Developer y desactivando JavaScript y CSS // Con la opción Miscellaneous > Linearize Page)

¿En qué orden aparecen los elementos en la página?

-AUDITORÍA DE POPULARIDAD-

GOOGLE SEARCH CONSOLE

SEO negativo

Linkbuilding hecho en el pasado

Compra/intercambio de enlaces

Redifusión de contenido

Plagio de contenidos con enlaces internos

Enlaces bienintencionados (aunque sospechosos)

Sitios web con más imágenes

Monitorizar enlaces

Descargamos todas las opciones posibles

Más enlaces de ejemplo

Enlaces más recientes

Descargamos un Excel y buscamos:

Site wide links

Listas de enlaces

Enlaces en footers o sidebars

Enlaces desde dominios con mala reputación

Enlaces con keyword o anchor text

Enlaces desde UGC (comentarios, foros, etc)

Muchos enlaces desde un dominio único

Enlaces con anchor text off topic

Enlaces desde dominios extraños

Muchos enlaces a una única página (home)

Enlaces entrantes:

Dominios desconocidos con un número muy elevado de enlaces en > Con más enlaces a tu sitio

Palabras clave irrelevantes en > Vinculación de tus datos

URL desconocidas en > Páginas más enlazadas

Crecimientos injustificados de enlaces hacia una página interna en > Páginas más enlazadas

Identificar palabras clave en el contenido > Consultas de búsqueda

SEMRUSH – Herramienta en la que centralizamos toda la gestión de los enlaces entrantes encontrados

Calidad de los dominios

Backlink Audit

Detección de enlaces tóxicos

Redes de enlaces

Spam en comunidades

Entorno perjudicial

Enlaces malipulativos

Dominio de origen irrelevante

Integrar con todas las fuentes posibles

Añadir enlaces de forma manual

Revisar de forma manual los casos dudosos

Eliminar/Desautorizar

Datos de enlace

Estado de la petición

Sugiere y facilita el envío del correo de petición

Gestión de la lista de desautorización

Generación del archivo y envío

Se comunica el envío y la herramienta recalcula el Toxic Score

Monitorización del enlazado

Seguimiento periódico de enlaces perdidos/ganados

OTRAS FORMAS DE SEO NEGATIVO

Ataques a dominios o hosting

Sitios hackeados

Velocidad de descarga

Manipulación de cabeceras HTTP

Inyección de malware

Infección para envío de spam

Content scraping

HERRAMIENTAS PARA ANALIZARLO

Screamingfrog: Monitoriza el comportamiento del sitio

SubVersion: Controla la fecha de actualización de los archivos en el servidor

Plugin de Wordpress: Mantenerlo siempre actualizado con el código de la web y del servidor

Revisar con frecuencia el contenido de las páginas indexadas de Google

QUÉ ANALIZAMOS

¿Hay cambios inexperados en el número de páginas indexadas?

Comprobar si Google ve contenido inapropiado en nuestro sitio

Comprobar que no haya problemas de seguridad en el sitio

¿Está la IP de nuestro servidor en una lista negra?

Copyscape: Para detectar contenido plagiado

Google Alerts: Configuramos nuestras alertas con marca, producto, etc

SemRush: ¿Aparecen errores y advertencias que no son coherentes con el matenimiento del código del sitio?

Sixtrix: ¿Aparecen errores y advertencias que no son coherentes con el matenimiento del código del sitio?